6.3: Condicionamento operante

- Page ID

- 185768

| Condicionamento clássico | Condicionamento operante | |

|---|---|---|

| abordagem de condicionamento | Um estímulo não condicionado (como comida) é combinado com um estímulo neutro (como um sino). O estímulo neutro eventualmente se torna o estímulo condicionado, que provoca a resposta condicionada (salivação). | O comportamento-alvo é seguido por reforço ou punição para fortalecê-lo ou enfraquecê-lo, para que o aluno tenha maior probabilidade de apresentar o comportamento desejado no futuro. |

| Tempo de estímulo | O estímulo ocorre imediatamente antes da resposta. | O estímulo (reforço ou punição) ocorre logo após a resposta. |

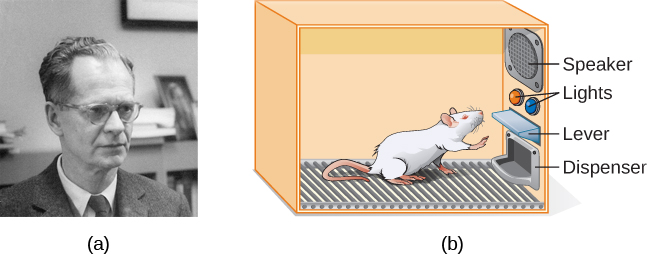

O psicólogo B. F. Skinner viu que o condicionamento clássico é limitado aos comportamentos existentes que são provocados reflexivamente e não explica novos comportamentos, como andar de bicicleta. Ele propôs uma teoria sobre como esses comportamentos surgem. Skinner acreditava que o comportamento é motivado pelas consequências que recebemos pelo comportamento: os reforços e punições. Sua ideia de que o aprendizado é o resultado de consequências é baseada na lei do efeito, proposta pela primeira vez pelo psicólogo Edward Thorndike. De acordo com a lei do efeito, comportamentos que são seguidos por consequências satisfatórias para o organismo têm maior probabilidade de se repetirem, e comportamentos seguidos por consequências desagradáveis têm menos probabilidade de se repetir (Thorndike, 1911). Essencialmente, se um organismo faz algo que traz o resultado desejado, é mais provável que o organismo faça isso novamente. Se um organismo faz algo que não traz o resultado desejado, é menos provável que o organismo o faça novamente. Um exemplo da lei do efeito está no emprego. Uma das razões (e muitas vezes a principal razão) de comparecermos para trabalhar é porque somos pagos para isso. Se pararmos de receber pagamentos, provavelmente deixaremos de aparecer, mesmo que amemos nosso trabalho.

Trabalhando com a lei do efeito de Thorndike como base, Skinner começou a conduzir experimentos científicos em animais (principalmente ratos e pombos) para determinar como os organismos aprendem por meio do condicionamento operante (Skinner, 1938). Ele colocou esses animais dentro de uma câmara de condicionamento operante, que ficou conhecida como “caixa Skinner” (Figura 6.10). Uma caixa Skinner contém uma alavanca (para ratos) ou disco (para pombos) que o animal pode pressionar ou bicar para receber uma recompensa alimentar por meio do dispensador. Alto-falantes e luzes podem estar associados a determinados comportamentos. Um gravador conta o número de respostas feitas pelo animal.

| Reforço e punição positivos e negativos | ||

|---|---|---|

| Reforço | Punição | |

| Positivo | Algo é adicionado para aumentar a probabilidade de um comportamento. | Algo é adicionado para diminuir a probabilidade de um comportamento. |

| Negativo | Algo é removido para aumentar a probabilidade de um comportamento. | Algo é removido para diminuir a probabilidade de um comportamento. |

Reforço

A maneira mais eficaz de ensinar um novo comportamento a uma pessoa ou animal é com reforço positivo. No reforço positivo, um estímulo desejável é adicionado para aumentar o comportamento.

Por exemplo, você diz a seu filho de cinco anos, Jerome, que se ele limpar o quarto, ganhará um brinquedo. Jerome limpa rapidamente seu quarto porque quer um novo conjunto de arte. Vamos fazer uma pausa por um momento. Algumas pessoas podem dizer: “Por que eu deveria recompensar meu filho por fazer o que é esperado?” Mas, na verdade, somos constantemente e consistentemente recompensados em nossas vidas. Nossos salários são recompensas, assim como as notas altas e a aceitação em nossa escola preferida. Ser elogiado por fazer um bom trabalho e por passar no teste de direção também é uma recompensa. O reforço positivo como ferramenta de aprendizagem é extremamente eficaz. Foi descoberto que uma das formas mais eficazes de aumentar o desempenho em distritos escolares com notas de leitura abaixo da média era pagar às crianças para ler. Especificamente, os alunos da segunda série em Dallas recebiam $2 cada vez que leram um livro e passaram por um pequeno questionário sobre o livro. O resultado foi um aumento significativo na compreensão de leitura (Fryer, 2010). O que você acha desse programa? Se Skinner estivesse vivo hoje, ele provavelmente pensaria que foi uma ótima ideia. Ele era um forte defensor do uso de princípios de condicionamento operante para influenciar o comportamento dos alunos na escola. Na verdade, além da caixa de Skinner, ele também inventou o que chamou de máquina de ensino projetada para recompensar pequenos passos no aprendizado (Skinner, 1961) — um dos primeiros precursores do aprendizado assistido por computador. Sua máquina de ensino testou o conhecimento dos alunos enquanto eles trabalhavam em várias disciplinas escolares. Se os alunos respondessem às perguntas corretamente, eles receberam reforço positivo imediato e poderiam continuar; se respondessem incorretamente, não receberam nenhum reforço. A ideia era que os estudantes passassem mais tempo estudando o material para aumentar suas chances de serem reforçados na próxima vez (Skinner, 1961).

No reforço negativo, um estímulo indesejável é removido para aumentar o comportamento. Por exemplo, os fabricantes de automóveis usam os princípios do reforço negativo em seus sistemas de cinto de segurança, que emitem “bipe, bipe” até você apertar o cinto de segurança. O som irritante para quando você exibe o comportamento desejado, aumentando a probabilidade de você apertar o cinto no futuro. O reforço negativo também é usado com frequência no treinamento de cavalos. Os cavaleiros exercem pressão — puxando as rédeas ou apertando as pernas — e depois removem a pressão quando o cavalo executa o comportamento desejado, como virar ou acelerar. A pressão é o estímulo negativo que o cavalo quer remover.

Punição

Muitas pessoas confundem reforço negativo com punição no condicionamento operante, mas são dois mecanismos muito diferentes. Lembre-se de que o reforço, mesmo quando é negativo, sempre aumenta o comportamento. Em contraste, a punição sempre diminui um comportamento. Na punição positiva, você adiciona um estímulo indesejável para diminuir um comportamento. Um exemplo de punição positiva é repreender um aluno para que ele pare de enviar mensagens de texto na sala de aula. Nesse caso, um estímulo (a reprimenda) é adicionado para diminuir o comportamento (mensagens de texto em sala de aula). Na punição negativa, você remove um estímulo agradável para diminuir o comportamento. Por exemplo, quando uma criança se comporta mal, um pai pode levar um brinquedo favorito. Nesse caso, um estímulo (o brinquedo) é removido para diminuir o comportamento.

A punição, especialmente quando é imediata, é uma forma de diminuir o comportamento indesejável. Por exemplo, imagine que seu filho de quatro anos, Brandon, bateu no irmão mais novo. Você faz Brandon escrever 100 vezes “Eu não vou bater no meu irmão” (punição positiva). É provável que ele não repita esse comportamento. Embora estratégias como essa sejam comuns hoje em dia, no passado, as crianças eram frequentemente sujeitas a punições físicas, como palmadas. É importante estar ciente de algumas das desvantagens de usar punição física em crianças. Primeiro, a punição pode ensinar medo. Brandon pode ficar com medo da rua, mas também pode ficar com medo da pessoa que aplicou a punição — você, seus pais. Da mesma forma, crianças que são punidas por professores podem passar a temer o professor e tentar evitar a escola (Gershoff et al., 2010). Consequentemente, a maioria das escolas nos Estados Unidos proibiu a punição corporal. Em segundo lugar, a punição pode fazer com que as crianças se tornem mais agressivas e propensas ao comportamento antissocial e à delinquência (Gershoff, 2002). Eles veem seus pais recorrerem à surra quando ficam com raiva e frustração, então, por sua vez, podem agir de acordo com esse mesmo comportamento quando ficam com raiva e frustração. Por exemplo, porque você bate em Brenda quando está com raiva dela por seu mau comportamento, ela pode começar a bater nas amigas quando elas não compartilham seus brinquedos.

Embora a punição positiva possa ser eficaz em alguns casos, Skinner sugeriu que o uso da punição deve ser ponderado em relação aos possíveis efeitos negativos. Os psicólogos e especialistas em paternidade de hoje preferem o reforço em vez da punição — eles recomendam que você pegue seu filho fazendo algo bom e o recompense por isso.

Moldando

Em seus experimentos de condicionamento operante, Skinner costumava usar uma abordagem chamada modelagem. Em vez de recompensar apenas o comportamento do alvo, na modelagem, recompensamos aproximações sucessivas de um comportamento alvo. Por que a modelagem é necessária? Lembre-se de que, para que o reforço funcione, o organismo deve primeiro exibir o comportamento. A modelagem é necessária porque é extremamente improvável que um organismo exiba espontaneamente qualquer coisa, exceto o mais simples dos comportamentos. Na modelagem, os comportamentos são divididos em muitas etapas pequenas e alcançáveis. As etapas específicas usadas no processo são as seguintes:

A modelagem é frequentemente usada para ensinar um comportamento complexo ou uma cadeia de comportamentos. Skinner usou a modelagem para ensinar aos pombos não apenas comportamentos relativamente simples, como bicar um disco em uma caixa de Skinner, mas também muitos comportamentos incomuns e divertidos, como girar em círculos, andar na figura oito e até mesmo jogar pingue-pongue; a técnica é comumente usada por treinadores de animais hoje. Uma parte importante da modelagem é a discriminação por estímulos. Lembre-se dos cães de Pavlov: ele os treinou para responder ao tom de um sino, e não a tons ou sons semelhantes. Essa discriminação também é importante no condicionamento operante e na formação do comportamento.

É fácil ver como a modelagem é eficaz no ensino de comportamentos aos animais, mas como a modelagem funciona com humanos? Vamos considerar os pais cujo objetivo é fazer com que seus filhos aprendam a limpar seu quarto. Eles usam a modelagem para ajudá-lo a dominar os passos em direção à meta. Em vez de realizar a tarefa inteira, eles configuram essas etapas e reforçam cada etapa. Primeiro, ele limpa um brinquedo. Segundo, ele limpa cinco brinquedos. Terceiro, ele escolhe entre pegar dez brinquedos ou guardar seus livros e roupas. Quarto, ele limpa tudo, exceto dois brinquedos. Finalmente, ele limpa todo o seu quarto.

Reforços primários e secundários

Recompensas como adesivos, elogios, dinheiro, brinquedos e muito mais podem ser usadas para reforçar o aprendizado. Vamos voltar aos ratos de Skinner novamente. Como os ratos aprenderam a pressionar a alavanca na caixa do Skinner? Eles eram recompensados com comida cada vez que pressionavam a alavanca. Para os animais, a comida seria um reforço óbvio.

O que seria um bom reforçador para humanos? Para seu filho Chris, era a promessa de um brinquedo quando eles limparam o quarto. E a Sydney, a jogadora de futebol? Se você desse um doce a Sydney toda vez que Sydney marcasse um gol, você estaria usando um reforço primário. Reforços primários são reforçadores que têm qualidades de reforço inatas. Esses tipos de reforçadores não são aprendidos. Água, comida, sono, abrigo, sexo e tato, entre outros, são os principais reforços. O prazer também é um reforço primário. Os organismos não perdem o ímpeto por essas coisas. Para a maioria das pessoas, pular em um lago fresco em um dia muito quente reforçaria e o lago frio reforçaria inatamente — a água refrescaria a pessoa (uma necessidade física), além de proporcionar prazer.

Um reforçador secundário não tem valor inerente e só tem qualidades de reforço quando vinculado a um reforçador primário. O elogio, ligado ao afeto, é um exemplo de reforço secundário, como quando você gritou “Ótimo tiro!” toda vez que Sydney fez um gol. Outro exemplo, dinheiro, só vale alguma coisa quando você pode usá-lo para comprar outras coisas — sejam coisas que satisfaçam as necessidades básicas (comida, água, abrigo — todos reforços primários) ou outros reforços secundários. Se você estivesse em uma ilha remota no meio do Oceano Pacífico e tivesse pilhas de dinheiro, o dinheiro não seria útil se você não pudesse gastá-lo. E quanto aos adesivos na tabela de comportamento? Eles também são reforçadores secundários.

Às vezes, em vez de adesivos em um gráfico de adesivos, um token é usado. Os tokens, que também são reforços secundários, podem então ser trocados por recompensas e prêmios. Sistemas inteiros de gerenciamento de comportamento, conhecidos como economias simbólicas, são construídos com base no uso desses tipos de reforçadores de tokens. Descobriu-se que as economias simbólicas são muito eficazes na modificação do comportamento em uma variedade de ambientes, como escolas, prisões e hospitais psiquiátricos. Por exemplo, um estudo de Cangi e Daly (2013) descobriu que o uso de uma economia simbólica aumentou os comportamentos sociais apropriados e reduziu os comportamentos inadequados em um grupo de crianças autistas em idade escolar. Crianças autistas tendem a apresentar comportamentos perturbadores, como beliscar e bater. Quando as crianças do estudo exibiram um comportamento adequado (sem bater ou beliscar), elas receberam um símbolo de “mãos quietas”. Quando eles bateram ou beliscaram, eles perderam uma ficha. As crianças poderiam então trocar quantidades específicas de fichas por minutos de brincadeira.

O tempo limite é outra técnica popular usada na modificação de comportamento com crianças. Ele opera com base no princípio da punição negativa. Quando uma criança demonstra um comportamento indesejável, ela é removida da atividade desejável em questão (Figura 6.12). Por exemplo, digamos que Sophia e seu irmão Mario estejam brincando com blocos de construção. Sophia joga alguns blocos em seu irmão, então você avisa que ela terá um tempo limite se fizer isso novamente. Alguns minutos depois, ela joga mais blocos em Mario. Você retira Sophia da sala por alguns minutos. Quando ela volta, ela não joga blocos.

Há vários pontos importantes que você deve saber se planeja implementar o tempo limite como uma técnica de modificação de comportamento. Primeiro, certifique-se de que a criança esteja sendo removida de uma atividade desejável e colocada em um local menos desejável. Se a atividade for algo indesejável para a criança, essa técnica sairá pela culatra porque é mais agradável para a criança ser removida da atividade. Em segundo lugar, a duração do tempo limite é importante. A regra geral é de um minuto para cada ano da idade da criança. Sophia tem cinco anos; portanto, ela fica sentada em um intervalo de cinco minutos. Definir um cronômetro ajuda as crianças a saberem quanto tempo precisam ficar sentadas no tempo limite. Por fim, como cuidador, lembre-se de várias diretrizes ao longo de um período de descanso: mantenha a calma ao orientar seu filho para uma pausa; ignore seu filho durante o intervalo (porque a atenção do cuidador pode reforçar o mau comportamento); e dê um abraço ou uma palavra gentil na criança quando o intervalo terminar.

Cronogramas de reforço

Lembre-se de que a melhor maneira de ensinar um comportamento a uma pessoa ou animal é usar reforço positivo. Por exemplo, Skinner usou reforço positivo para ensinar ratos a pressionar uma alavanca em uma caixa de Skinner. No início, o rato poderia bater aleatoriamente na alavanca enquanto explorava a caixa, e saía uma pastilha de comida. Depois de comer o pellet, o que você acha que o rato faminto fez a seguir? Ele bateu na alavanca novamente e recebeu outra pastilha de comida. Cada vez que o rato tocava na alavanca, saía um pedaço de comida. Quando um organismo recebe um reforçador cada vez que apresenta um comportamento, isso é chamado de reforço contínuo. Esse cronograma de reforço é a maneira mais rápida de ensinar um comportamento a alguém e é especialmente eficaz no treinamento de um novo comportamento. Vamos relembrar o cachorro que estava aprendendo a se sentar no início do capítulo. Agora, cada vez que ele se senta, você lhe dá uma guloseima. O tempo é importante aqui: você terá mais sucesso se apresentar o reforçador imediatamente após ele se sentar, para que ele possa fazer uma associação entre o comportamento do alvo (sentado) e a consequência (receber uma guloseima).

| Cronogramas de reforço | |||

|---|---|---|---|

| Cronograma de reforço | Descrição | Resultado | Exemplo |

| Intervalo fixo | O reforço é entregue em intervalos de tempo previsíveis (por exemplo, após 5, 10, 15 e 20 minutos). | Taxa de resposta moderada com pausas significativas após o reforço | Paciente hospitalar usa alívio da dor controlado pelo paciente e cronometrado pelo médico |

| Intervalo variável | O reforço é entregue em intervalos de tempo imprevisíveis (por exemplo, após 5, 7, 10 e 20 minutos). | Taxa de resposta moderada, porém estável | Verificando o Facebook |

| Proporção fixa | O reforço é fornecido após um número previsível de respostas (por exemplo, após 2, 4, 6 e 8 respostas). | Alta taxa de resposta com pausas após o reforço | Trabalho por peça — Trabalhador de fábrica sendo pago por cada x número de itens fabricados |

| Proporção variável | O reforço é fornecido após um número imprevisível de respostas (por exemplo, após 1, 4, 5 e 9 respostas). | Taxa de resposta alta e estável | Jogos de azar |

Agora vamos combinar esses quatro termos. Um cronograma de reforço de intervalo fixo é quando o comportamento é recompensado após um determinado período de tempo. Por exemplo, June passa por uma grande cirurgia em um hospital. Durante a recuperação, espera-se que ela sinta dor e precise de medicamentos prescritos para alívio da dor. June recebe um gotejamento intravenoso com um analgésico controlado pelo paciente. Seu médico define um limite: uma dose por hora. June aperta um botão quando a dor fica difícil e recebe uma dose de medicamento. Como a recompensa (alívio da dor) só ocorre em um intervalo fixo, não adianta exibir o comportamento quando ele não será recompensado.

Com um cronograma de reforço de intervalo variável, a pessoa ou animal recebe o reforço com base em quantidades variáveis de tempo, que são imprevisíveis. Digamos que Manuel seja o gerente de um restaurante de fast-food. De vez em quando, alguém da divisão de controle de qualidade vai ao restaurante do Manuel. Se o restaurante estiver limpo e o serviço for rápido, todos nesse turno ganharão um bônus de $20. Manuel nunca sabe quando o responsável pelo controle de qualidade vai aparecer, então ele sempre tenta manter o restaurante limpo e garante que seus funcionários prestem um serviço rápido e cortês. Sua produtividade em relação ao atendimento rápido e à manutenção de um restaurante limpo é estável porque ele quer que sua equipe ganhe o bônus.

Com um cronograma de reforço de proporção fixa, há um número definido de respostas que devem ocorrer antes que o comportamento seja recompensado. Carla vende óculos em uma loja de óculos e ganha uma comissão toda vez que vende um par de óculos. Ela sempre tenta vender às pessoas mais pares de óculos, incluindo óculos de sol prescritos ou um par alternativo, para que ela possa aumentar sua comissão. Ela não se importa se a pessoa realmente precisa dos óculos de sol prescritos, Carla só quer seu bônus. A qualidade do que Carla vende não importa porque sua comissão não é baseada na qualidade; é baseada apenas no número de pares vendidos. Essa distinção na qualidade do desempenho pode ajudar a determinar qual método de reforço é mais apropriado para uma situação específica. As taxas fixas são mais adequadas para otimizar a quantidade de produção, enquanto um intervalo fixo, no qual a recompensa não é baseada na quantidade, pode levar a uma maior qualidade da produção.

Em um cronograma de reforço de proporção variável, o número de respostas necessárias para uma recompensa varia. Esse é o cronograma de reforço parcial mais poderoso. Um exemplo do cronograma de reforço de proporção variável é o jogo. Imagine que Sarah, geralmente uma mulher inteligente e econômica, visite Las Vegas pela primeira vez. Ela não é uma jogadora, mas por curiosidade ela coloca uma moeda na máquina caça-níqueis, depois outra e outra. Nada acontece. Dois dólares em trimestres depois, sua curiosidade está desaparecendo e ela está prestes a desistir. Mas então, a máquina acende, os sinos tocam e Sarah recebe 50 moedas de volta. É mais parecido com isso! Sarah volta a inserir trimestres com juros renovados e, alguns minutos depois, ela esgotou todos os seus ganhos e está $10 no buraco. Agora pode ser um momento sensato para parar. No entanto, ela continua investindo dinheiro na máquina caça-níqueis porque nunca sabe quando o próximo reforço chegará. Ela continua pensando que no próximo trimestre ela poderia ganhar $50, $100 ou até mais. Como o cronograma de reforço na maioria dos tipos de jogos de azar tem um cronograma de proporção variável, as pessoas continuam tentando e esperando que na próxima vez ganhem muito. Essa é uma das razões pelas quais o jogo é tão viciante e resistente à extinção.

No condicionamento operante, a extinção de um comportamento reforçado ocorre em algum momento após a interrupção do reforço, e a velocidade com que isso acontece depende do cronograma de reforço. Em um cronograma de proporção variável, o ponto de extinção chega muito lentamente, conforme descrito acima. Mas nos outros cronogramas de reforço, a extinção pode chegar rapidamente. Por exemplo, se June pressionar o botão do medicamento para alívio da dor antes do prazo estabelecido pelo médico, nenhum medicamento será administrado. Ela está em um cronograma de reforço de intervalo fixo (dosado a cada hora), então a extinção ocorre rapidamente quando o reforço não chega no horário esperado. Entre os esquemas de reforço, a proporção variável é a mais produtiva e a mais resistente à extinção. O intervalo fixo é o menos produtivo e o mais fácil de extinguir (Figura 6.13).

Skinner (1953) declarou: “Se o estabelecimento de jogos de azar não conseguir persuadir um cliente a entregar dinheiro sem retorno, ele pode obter o mesmo efeito ao devolver parte do dinheiro do cliente em um cronograma de proporção variável” (p. 397).

Skinner usa o jogo como um exemplo do poder do cronograma de reforço de proporção variável para manter o comportamento mesmo durante longos períodos sem qualquer reforço. Na verdade, Skinner estava tão confiante em seu conhecimento do vício em jogos de azar que até afirmou que poderia transformar um pombo em um jogador patológico (“Skinner's Utopia”, 1971). De fato, é verdade que os horários de proporção variável mantêm o comportamento bastante persistente - imagine a frequência das birras de uma criança se um pai ceder pelo menos uma vez ao comportamento. A recompensa ocasional torna quase impossível interromper o comportamento.

Pesquisas recentes em ratos falharam em apoiar a ideia de Skinner de que o treinamento em horários de proporção variável por si só causa jogos de azar patológicos (Laskowski et al., 2019). No entanto, outras pesquisas sugerem que o jogo parece funcionar no cérebro da mesma forma que a maioria das drogas viciantes e, portanto, pode haver alguma combinação de química cerebral e cronograma de reforço que pode levar a problemas de jogo (Figura 6.14). Especificamente, pesquisas modernas mostram a conexão entre o jogo e a ativação dos centros de recompensa do cérebro que usam o neurotransmissor (químico cerebral) dopamina (Murch & Clark, 2016). Curiosamente, os jogadores nem precisam vencer para experimentar a “onda” da dopamina no cérebro. Também foi demonstrado que “quase erros”, ou quase ganhando, mas não realmente ganhando, aumenta a atividade no estriado ventral e em outros centros de recompensa cerebral que usam dopamina (Chase & Clark, 2010). Esses efeitos cerebrais são quase idênticos aos produzidos por drogas viciantes, como cocaína e heroína (Murch & Clark, 2016). Com base nas evidências neurocientíficas que mostram essas semelhanças, o DSM-5 agora considera o jogo um vício, enquanto as versões anteriores do DSM classificaram o jogo como um transtorno de controle de impulsos.

Além da dopamina, o jogo também parece envolver outros neurotransmissores, incluindo norepinefrina e serotonina (Potenza, 2013). A norepinefrina é secretada quando uma pessoa sente estresse, excitação ou emoção. Pode ser que jogadores patológicos usem jogos de azar para aumentar seus níveis desse neurotransmissor. Deficiências na serotonina também podem contribuir para o comportamento compulsivo, incluindo o vício em jogos de azar (Potenza, 2013).

Pode ser que os cérebros dos jogadores patológicos sejam diferentes dos de outras pessoas, e talvez essa diferença possa de alguma forma ter levado ao vício do jogo, como esses estudos parecem sugerir. No entanto, é muito difícil determinar a causa porque é impossível conduzir um experimento verdadeiro (não seria ético tentar transformar participantes designados aleatoriamente em jogadores problemáticos). Portanto, pode ser que a causalidade realmente se mova na direção oposta - talvez o ato de jogar de alguma forma altere os níveis de neurotransmissores no cérebro de alguns jogadores. Também é possível que algum fator negligenciado, ou variável de confusão, tenha desempenhado um papel tanto no vício do jogo quanto nas diferenças na química cerebral.

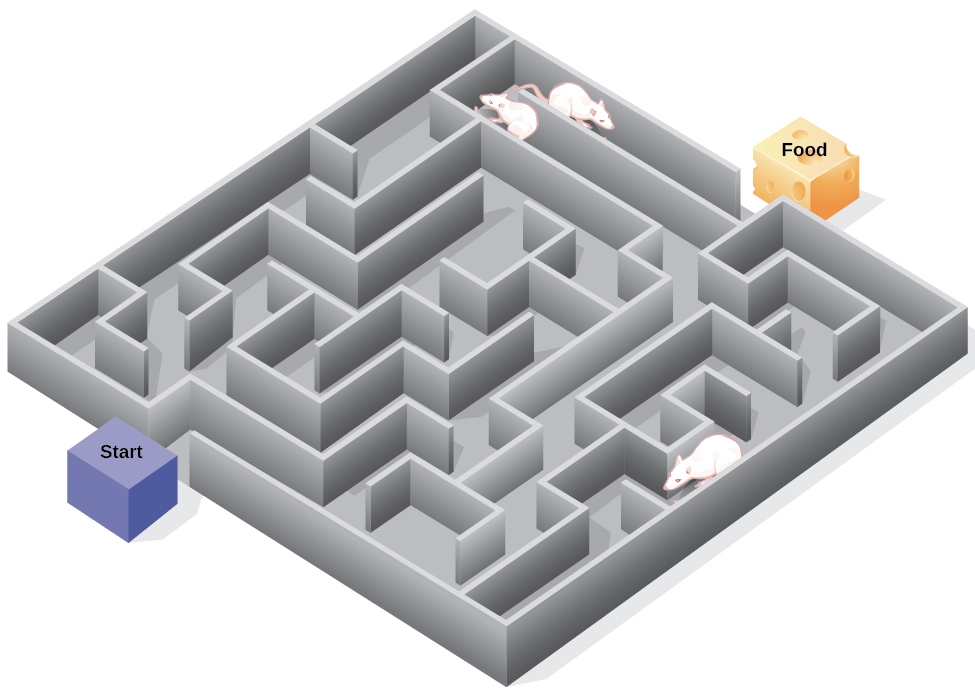

Cognição e aprendizagem latente

Comportamentalistas rigorosos como Watson e Skinner se concentraram exclusivamente em estudar o comportamento em vez da cognição (como pensamentos e expectativas). Na verdade, Skinner acreditava firmemente que a cognição não importava que suas ideias fossem consideradas um behaviorismo radical. Skinner considerava a mente uma “caixa preta” — algo completamente incognoscível — e, portanto, algo que não deveria ser estudado. No entanto, outro behaviorista, Edward C. Tolman, tinha uma opinião diferente. Os experimentos de Tolman com ratos demonstraram que os organismos podem aprender mesmo que não recebam reforço imediato (Tolman & Honzik, 1930; Tolman, Ritchie e Kalish, 1946). Essa descoberta estava em conflito com a ideia predominante na época de que o reforço deve ser imediato para que o aprendizado ocorra, sugerindo assim um aspecto cognitivo para a aprendizagem.

Nos experimentos, Tolman colocou ratos famintos em um labirinto sem nenhuma recompensa por encontrarem seu caminho. Ele também estudou um grupo de comparação que foi recompensado com comida no final do labirinto. Enquanto os ratos não reforçados exploravam o labirinto, eles desenvolveram um mapa cognitivo: uma imagem mental do layout do labirinto (Figura 6.15). Após 10 sessões no labirinto sem reforço, a comida foi colocada em uma caixa de gol no final do labirinto. Assim que os ratos tomaram conhecimento da comida, eles conseguiram encontrar seu caminho pelo labirinto rapidamente, tão rapidamente quanto o grupo de comparação, que havia sido recompensado com comida o tempo todo. Isso é conhecido como aprendizado latente: aprendizado que ocorre, mas não é observável no comportamento até que haja uma razão para demonstrá-lo.

Você já se perdeu em um prédio e não conseguiu encontrar o caminho de volta? Embora isso possa ser frustrante, você não está sozinho. Em um momento ou outro, todos nós nos perdemos em lugares como um museu, hospital ou biblioteca universitária. Sempre que vamos a algum lugar novo, construímos uma representação mental — ou mapa cognitivo — do local, enquanto os ratos de Tolman construíam um mapa cognitivo de seu labirinto. No entanto, alguns edifícios são confusos porque incluem muitas áreas parecidas ou com linhas de visão curtas. Por causa disso, muitas vezes é difícil prever o que está ao virar da esquina ou decidir se quer virar à esquerda ou à direita para sair de um prédio. A psicóloga Laura Carlson (2010) sugere que o que colocamos em nosso mapa cognitivo pode impactar nosso sucesso na navegação pelo meio ambiente. Ela sugere que prestar atenção a características específicas ao entrar em um prédio, como uma foto na parede, uma fonte, uma estátua ou uma escada rolante, adiciona informações ao nosso mapa cognitivo que podem ser usadas posteriormente para ajudar a encontrar a saída do prédio.