6.3 : Conditionnement du dispositif opératoire

- Page ID

- 192939

| Conditionnement classique | Conditionnement opérant | |

|---|---|---|

| Approche de conditionnement | Un stimulus non conditionné (tel que de la nourriture) est associé à un stimulus neutre (comme une cloche). Le stimulus neutre finit par devenir le stimulus conditionné, qui provoque la réponse conditionnée (salivation). | Le comportement cible est suivi d'un renforcement ou d'une punition visant à le renforcer ou à l'affaiblir, afin que l'apprenant soit plus susceptible de présenter le comportement souhaité à l'avenir. |

| Synchronisation du stimulus | Le stimulus se produit immédiatement avant la réponse. | Le stimulus (renforcement ou punition) intervient peu de temps après la réponse. |

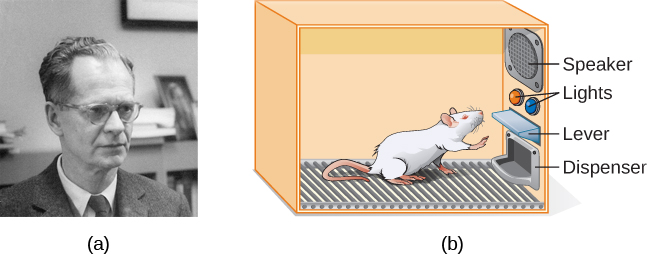

Le psychologue B.F. Skinner a constaté que le conditionnement classique se limite aux comportements existants qui sont provoqués par réflexe, et qu'il ne tient pas compte des nouveaux comportements tels que le vélo. Il a proposé une théorie sur la façon dont de tels comportements se produisent. Skinner pensait que le comportement est motivé par les conséquences que nous recevons pour le comportement : les renforts et les punitions. Son idée selon laquelle l'apprentissage est le résultat de conséquences est basée sur la loi de l'effet, proposée pour la première fois par le psychologue Edward Thorndike. Selon la loi de l'effet, les comportements qui sont suivis de conséquences satisfaisantes pour l'organisme sont plus susceptibles de se répéter, et les comportements suivis de conséquences désagréables sont moins susceptibles de se répéter (Thorndike, 1911). Essentiellement, si un organisme fait quelque chose qui donne le résultat souhaité, il est plus susceptible de le faire à nouveau. Si un organisme fait quelque chose qui n'aboutit pas au résultat souhaité, il est moins susceptible de le refaire. L'emploi est un exemple de la loi applicable. L'une des raisons (et souvent la principale) pour lesquelles nous nous présentons au travail est que nous sommes payés pour le faire. Si nous cessons d'être payés, nous cesserons probablement de nous présenter, même si nous aimons notre travail.

S'appuyant sur la loi des effets de Thorndike, Skinner a commencé à mener des expériences scientifiques sur des animaux (principalement des rats et des pigeons) afin de déterminer comment les organismes apprennent grâce au conditionnement opérant (Skinner, 1938). Il a placé ces animaux dans une chambre de conditionnement fonctionnelle, connue sous le nom de « boîte Skinner » (Figure 6.10). Une boîte Skinner contient un levier (pour les rats) ou un disque (pour les pigeons) que l'animal peut presser ou picorer pour obtenir une récompense alimentaire via le distributeur. Les haut-parleurs et les lumières peuvent être associés à certains comportements. Un enregistreur compte le nombre de réponses de l'animal.

| Renforcement et punition positifs et négatifs | ||

|---|---|---|

| Renfort | Châtiment | |

| positif | Quelque chose est ajouté pour augmenter la probabilité d'un comportement. | Quelque chose est ajouté pour diminuer la probabilité d'un comportement. |

| NÉGATIF | Quelque chose est supprimé pour augmenter la probabilité d'un comportement. | Quelque chose est supprimé pour réduire la probabilité d'un comportement. |

Renfort

Le moyen le plus efficace d'enseigner à une personne ou à un animal un nouveau comportement est le renforcement positif. En cas de renforcement positif, un stimulus souhaitable est ajouté pour augmenter le comportement.

Par exemple, vous dites à votre fils de cinq ans, Jérôme, que s'il nettoie sa chambre, il obtiendra un jouet. Jérôme nettoie rapidement sa chambre car il veut un nouveau set d'art. Arrêtons-nous un instant. Certaines personnes pourraient se demander : « Pourquoi devrais-je récompenser mon enfant pour avoir fait ce qui est attendu ? » Mais en fait, nous sommes constamment et régulièrement récompensés dans notre vie. Nos salaires sont des récompenses, tout comme les notes élevées et l'acceptation dans notre école préférée. Être félicité pour son bon travail et pour avoir réussi un examen de conduite est également une récompense. Le renforcement positif en tant qu'outil d'apprentissage est extrêmement efficace. Il s'est avéré que l'un des moyens les plus efficaces d'améliorer les résultats scolaires dans les districts scolaires dont les résultats en lecture sont inférieurs à la moyenne était de payer les enfants pour qu'ils lisent. Plus précisément, les élèves de deuxième année de Dallas recevaient 2 dollars chaque fois qu'ils lisaient un livre et répondaient à un court questionnaire sur le livre. Il en a résulté une augmentation significative de la compréhension écrite (Fryer, 2010). Que pensez-vous de ce programme ? Si Skinner était vivant aujourd'hui, il penserait probablement que c'est une bonne idée. Il était un fervent partisan de l'utilisation de principes de conditionnement opérant pour influencer le comportement des élèves à l'école. En fait, outre la boîte Skinner, il a également inventé ce qu'il a appelé une machine pédagogique conçue pour récompenser les petits pas dans l'apprentissage (Skinner, 1961), précurseur de l'apprentissage assisté par ordinateur. Sa machine pédagogique a testé les connaissances des étudiants pendant qu'ils travaillaient sur diverses matières scolaires. Si les élèves répondaient correctement aux questions, ils recevaient un renforcement positif immédiat et pouvaient continuer ; s'ils répondaient incorrectement, ils ne recevaient aucun renforcement. L'idée était que les étudiants passeraient plus de temps à étudier la matière pour augmenter leurs chances d'être renforcés la prochaine fois (Skinner, 1961).

En cas de renforcement négatif, un stimulus indésirable est éliminé pour augmenter le comportement. Par exemple, les constructeurs automobiles utilisent le principe du renforcement négatif dans leurs systèmes de ceinture de sécurité, qui émet des « bips, bips » jusqu'à ce que vous attachiez votre ceinture de sécurité. Le son gênant s'arrête lorsque vous adoptez le comportement souhaité, ce qui augmente la probabilité que vous vous retrouviez à l'avenir. Le renforcement négatif est également fréquemment utilisé dans l'entraînement des chevaux. Les cavaliers exercent une pression, en tirant sur les rênes ou en serrant leurs jambes, puis relâchent la pression lorsque le cheval adopte le comportement souhaité, comme tourner ou accélérer. La pression est le stimulus négatif que le cheval veut supprimer.

Châtiment

Beaucoup de gens confondent renforcement négatif et punition dans le conditionnement opérant, mais ce sont deux mécanismes très différents. Rappelez-vous que le renforcement, même lorsqu'il est négatif, augmente toujours un comportement. En revanche, la punition diminue toujours un comportement. En cas de punition positive, vous ajoutez un stimulus indésirable pour diminuer un comportement. Un exemple de punition positive est de réprimander un élève pour qu'il arrête d'envoyer des SMS en classe. Dans ce cas, un stimulus (la réprimande) est ajouté afin de diminuer le comportement (texter en classe). En cas de punition négative, vous supprimez un stimulus agréable pour diminuer le comportement. Par exemple, lorsqu'un enfant se comporte mal, un parent peut emporter son jouet préféré. Dans ce cas, un stimulus (le jouet) est supprimé afin de diminuer le comportement.

La punition, surtout lorsqu'elle est immédiate, est un moyen de réduire les comportements indésirables. Par exemple, imaginez que votre fils de quatre ans, Brandon, frappe son frère cadet. Vous demandez à Brandon d'écrire 100 fois « Je ne frapperai pas mon frère » (punition positive). Il y a de fortes chances qu'il ne répète pas ce comportement. Bien que de telles stratégies soient courantes aujourd'hui, par le passé, les enfants étaient souvent soumis à des châtiments corporels, tels que la fessée. Il est important d'être conscient de certains des inconvénients liés à l'utilisation de châtiments corporels sur les enfants. Tout d'abord, la punition peut enseigner la peur. Brandon peut avoir peur de la rue, mais il peut aussi avoir peur de la personne qui a infligé le châtiment, vous, son parent. De même, les enfants punis par les enseignants peuvent avoir peur de l'enseignant et essayer d'éviter l'école (Gershoff et al., 2010). Par conséquent, la plupart des écoles des États-Unis ont interdit les châtiments corporels. Deuxièmement, la punition peut rendre les enfants plus agressifs et les exposer à des comportements antisociaux et à la délinquance (Gershoff, 2002). Ils voient leurs parents recourir à la fessée lorsqu'ils sont en colère et frustrés, alors, à leur tour, ils peuvent adopter le même comportement lorsqu'ils sont en colère et frustrés. Par exemple, si vous donnez une fessée à Brenda lorsque vous êtes en colère contre elle pour son mauvais comportement, elle peut commencer à frapper ses amis lorsqu'ils ne veulent pas partager leurs jouets.

Bien qu'une punition positive puisse être efficace dans certains cas, Skinner a suggéré que le recours à la punition soit mis en balance avec les effets négatifs possibles. Les psychologues et les experts parentaux d'aujourd'hui privilégient le renforcement plutôt que la punition. Ils recommandent de surprendre votre enfant en train de faire quelque chose de bien et de le récompenser pour cela.

Formage

Dans ses expériences de conditionnement opérant, Skinner a souvent utilisé une approche appelée mise en forme. Au lieu de récompenser uniquement le comportement cible, lors de la mise en forme, nous récompensons les approximations successives d'un comportement cible. Pourquoi le façonnage est-il nécessaire ? N'oubliez pas que pour que le renforcement fonctionne, l'organisme doit d'abord afficher son comportement. La mise en forme est nécessaire car il est extrêmement peu probable qu'un organisme affiche spontanément autre chose que le comportement le plus simple. Lors de la mise en forme, les comportements sont décomposés en de nombreuses petites étapes réalisables. Les étapes spécifiques utilisées dans le processus sont les suivantes :

La mise en forme est souvent utilisée pour enseigner un comportement complexe ou une chaîne de comportements. Skinner a utilisé la mise en forme pour enseigner aux pigeons non seulement des comportements relativement simples tels que picorer un disque dans une boîte Skinner, mais aussi de nombreux comportements inhabituels et divertissants, tels que tourner en rond, marcher en huit et même jouer au ping-pong ; cette technique est couramment utilisée par les dresseurs d'animaux aujourd'hui. La discrimination liée aux stimuli joue un rôle important dans le façonnage. Souvenez-vous des chiens de Pavlov : il leur a appris à réagir au son d'une cloche et non à des sons ou à des sons similaires. Cette discrimination est également importante dans le conditionnement des agents et dans la formation du comportement.

Il est facile de voir à quel point la mise en forme est efficace pour enseigner les comportements aux animaux, mais comment fonctionne la mise en forme chez les humains ? Prenons l'exemple des parents dont l'objectif est de faire apprendre à leur enfant à nettoyer sa chambre. Ils utilisent la mise en forme pour l'aider à maîtriser les étapes vers l'objectif. Au lieu d'effectuer l'intégralité de la tâche, ils configurent ces étapes et renforcent chaque étape. Tout d'abord, il nettoie un jouet. Ensuite, il nettoie cinq jouets. Troisièmement, il choisit de ramasser dix jouets ou de ranger ses livres et ses vêtements. Quatrièmement, il nettoie tout sauf deux jouets. Enfin, il nettoie toute sa pièce.

Renforts primaires et secondaires

Des récompenses telles que des autocollants, des éloges, de l'argent, des jouets, etc. peuvent être utilisées pour renforcer l'apprentissage. Revenons aux rats de Skinner. Comment les rats ont-ils appris à appuyer sur le levier de la boîte Skinner ? Ils étaient récompensés par de la nourriture chaque fois qu'ils appuyaient sur le levier. Pour les animaux, la nourriture serait un atout évident.

Quel serait un bon renforçateur pour les humains ? Pour votre enfant Chris, c'était la promesse d'un jouet lorsqu'il a nettoyé sa chambre. Et Sydney, la joueuse de foot ? Si vous donniez un bonbon à Sydney à chaque fois que Sydney marquait un but, vous utiliseriez un renfort principal. Les renforts primaires sont des renforts qui possèdent des qualités de renforcement innées. Ces types de renforts ne sont pas appris. L'eau, la nourriture, le sommeil, le logement, le sexe et le toucher, entre autres, sont les principaux facteurs de renforcement. Le plaisir est également l'un des principaux facteurs de renforcement. Les organismes ne perdent pas leur motivation pour ces choses. Pour la plupart des gens, sauter dans un lac frais par une journée très chaude serait réconfortant, et la fraîcheur du lac se renforcerait naturellement : l'eau rafraîchirait la personne (un besoin physique) et procurerait du plaisir.

Un renforçateur secondaire n'a aucune valeur intrinsèque et ne possède des qualités de renforcement que lorsqu'il est associé à un renforçateur principal. La louange, associée à l'affection, est un exemple de renforcement secondaire, comme lorsque vous avez crié « Super coup ! » chaque fois que Sydney a marqué un but. Autre exemple, l'argent ne vaut quelque chose que lorsque vous pouvez l'utiliser pour acheter d'autres choses, soit des biens qui répondent à des besoins de base (nourriture, eau, abris, tous des renforts principaux), soit d'autres renforts secondaires. Si vous vous trouviez sur une île isolée au milieu de l'océan Pacifique et que vous aviez des tas d'argent, cet argent ne serait pas utile si vous ne pouviez pas le dépenser. Qu'en est-il des autocollants sur la charte comportementale ? Ils sont également des renforts secondaires.

Parfois, au lieu d'autocollants sur un tableau d'autocollants, un jeton est utilisé. Les jetons, qui sont également des renforts secondaires, peuvent ensuite être échangés contre des récompenses et des prix. Des systèmes complets de gestion du comportement, connus sous le nom d'économies de jetons, sont construits autour de l'utilisation de ce type de renforçateurs de jetons. Les économies symboliques se sont révélées très efficaces pour modifier les comportements dans divers contextes tels que les écoles, les prisons et les hôpitaux psychiatriques. Par exemple, une étude menée par Cangi et Daly (2013) a révélé que l'utilisation d'une économie symbolique augmentait les comportements sociaux appropriés et réduisait les comportements inappropriés chez un groupe d'écoliers autistes. Les enfants autistes ont tendance à avoir des comportements perturbateurs tels que pincer et frapper. Lorsque les enfants participant à l'étude ont fait preuve d'un comportement approprié (ne pas frapper ni pincer), ils ont reçu un signe « mains calmes ». Lorsqu'ils frappaient ou pinçaient, ils perdaient un jeton. Les enfants pouvaient ensuite échanger des quantités spécifiées de jetons contre des minutes de jeu.

Le temps mort est une autre technique populaire utilisée pour modifier le comportement des enfants. Il fonctionne selon le principe du châtiment négatif. Lorsqu'un enfant manifeste un comportement indésirable, il est retiré de l'activité souhaitée (Figure 6.12). Par exemple, disons que Sophia et son frère Mario jouent avec des blocs de construction. Sophia lance quelques blocs à son frère, alors vous l'avertissez qu'elle fera une pause si elle recommence. Quelques minutes plus tard, elle lance d'autres blocs sur Mario. Vous faites sortir Sophia de la pièce pendant quelques minutes. Quand elle revient, elle ne lance pas de blocs.

Il y a plusieurs points importants que vous devez savoir si vous envisagez de mettre en œuvre le timeout en tant que technique de modification du comportement. Tout d'abord, assurez-vous que l'enfant est retiré d'une activité souhaitable et placé dans un endroit moins souhaitable. Si l'activité n'est pas souhaitable pour l'enfant, cette technique aura des effets négatifs, car il est plus agréable pour l'enfant d'être retiré de l'activité. Deuxièmement, la durée du délai d'attente est importante. La règle générale est d'une minute pour chaque année d'âge de l'enfant. Sophia a cinq ans ; elle est donc assise dans un temps mort de cinq minutes. Le réglage d'une minuterie permet aux enfants de savoir combien de temps ils doivent rester assis pendant le temps mort. Enfin, en tant que soignant, gardez à l'esprit plusieurs directives au cours d'une pause : restez calme lorsque vous demandez à votre enfant de s'absenter ; ignorez votre enfant pendant le temps mort (car l'attention du soignant peut renforcer l'inconduite) ; et faites-lui un câlin ou un mot gentil lorsque le temps mort est terminé.

Horaires de renforcement

N'oubliez pas que la meilleure façon d'enseigner un comportement à une personne ou à un animal est d'utiliser le renforcement positif. Par exemple, Skinner a utilisé le renforcement positif pour apprendre aux rats à appuyer sur un levier dans une boîte Skinner. Au début, le rat pouvait appuyer sur le levier au hasard en explorant la boîte, et une pastille de nourriture en ressortait. Après avoir mangé le granulé, que pensez-vous que le rat affamé a fait ensuite ? Il a de nouveau heurté le levier et a reçu une autre pastille de nourriture. Chaque fois que le rat frappait le levier, une pastille de nourriture sortait. Lorsqu'un organisme reçoit un renforçateur à chaque fois qu'il affiche un comportement, on parle de renforcement continu. Ce programme de renforcement est le moyen le plus rapide d'enseigner un comportement à quelqu'un, et il est particulièrement efficace pour entraîner un nouveau comportement. Revenons au chien qui apprenait à s'asseoir plus tôt dans le chapitre. Maintenant, à chaque fois qu'il s'assoit, tu lui fais une friandise. Le timing est important ici : vous aurez plus de succès si vous présentez le renforçateur immédiatement après qu'il se soit assis, afin qu'il puisse établir un lien entre le comportement cible (position assise) et les conséquences (recevoir un traitement).

| Horaires de renforcement | |||

|---|---|---|---|

| Calendrier de renforcement | Désignation | Résultat | Exemple |

| Intervalle fixe | Le renforcement est fourni à des intervalles de temps prévisibles (par exemple, après 5, 10, 15 et 20 minutes). | Taux de réponse modéré avec des pauses importantes après le renforcement | Un patient hospitalisé utilise un soulagement de la douleur contrôlé par le patient et programmé par le médecin |

| Intervalle variable | Le renforcement est fourni à des intervalles de temps imprévisibles (par exemple, après 5, 7, 10 et 20 minutes). | Taux de réponse modéré mais constant | Consulter Facebook |

| Ratio fixe | Le renforcement est fourni après un nombre prévisible de réponses (par exemple, après 2, 4, 6 et 8 réponses). | Taux de réponse élevé avec des pauses après le renforcement | Travail à la pièce : un ouvrier d'usine est payé pour chaque x nombre d'articles fabriqués |

| Ratio variable | Le renforcement est fourni après un nombre imprévisible de réponses (par exemple, après 1, 4, 5 et 9 réponses). | Taux de réponse élevé et constant | Le jeu |

Combinons maintenant ces quatre termes. Un calendrier de renforcement à intervalle fixe consiste à récompenser le comportement après un certain temps. Par exemple, June subit une intervention chirurgicale majeure dans un hôpital. Pendant sa convalescence, elle devrait ressentir de la douleur et avoir besoin de médicaments sur ordonnance pour soulager la douleur. June reçoit une perfusion intraveineuse contenant un analgésique contrôlé par le patient. Son médecin fixe une limite : une dose par heure. June appuie sur un bouton lorsque la douleur devient intense, et elle reçoit une dose de médicament. Puisque la récompense (soulagement de la douleur) ne se produit que sur un intervalle fixe, il ne sert à rien de montrer un comportement lorsqu'il ne sera pas récompensé.

Avec un programme de renforcement à intervalles variables, la personne ou l'animal reçoit le renforcement en fonction de périodes variables, qui sont imprévisibles. Disons que Manuel est le directeur d'un restaurant de restauration rapide. De temps en temps, un membre de la division du contrôle de la qualité vient au restaurant Manuel's. Si le restaurant est propre et que le service est rapide, tous les employés de ce quart de travail gagnent un bonus de 20$. Manuel ne sait jamais quand le responsable du contrôle qualité se présentera. Il essaie donc toujours de garder le restaurant propre et veille à ce que ses employés fournissent un service rapide et courtois. Sa productivité en matière de service rapide et de propreté du restaurant est constante parce qu'il veut que son équipe gagne le bonus.

Avec un calendrier de renforcement à ratio fixe, un certain nombre de réponses doivent se produire avant que le comportement ne soit récompensé. Carla vend des lunettes dans un magasin de lunettes, et elle gagne une commission chaque fois qu'elle vend une paire de lunettes. Elle essaie toujours de vendre aux gens plus de paires de lunettes, y compris des lunettes de soleil sur ordonnance ou une paire de rechange, afin d'augmenter sa commission. Peu importe que la personne ait vraiment besoin de lunettes de soleil sur ordonnance, Carla veut juste son bonus. La qualité de ce que Carla vend n'a pas d'importance, car sa commission n'est pas basée sur la qualité ; elle est uniquement basée sur le nombre de paires vendues. Cette distinction dans la qualité des performances peut aider à déterminer la méthode de renforcement la plus appropriée pour une situation particulière. Les ratios fixes sont mieux adaptés pour optimiser la quantité de production, tandis qu'un intervalle fixe, dans lequel la récompense n'est pas basée sur la quantité, peut conduire à une meilleure qualité de production.

Dans un programme de renforcement à ratio variable, le nombre de réponses nécessaires pour obtenir une récompense varie. Il s'agit du programme de renforcement partiel le plus puissant. Les jeux de hasard sont un exemple de programme de renforcement à ratio variable. Imaginez que Sarah, généralement une femme intelligente et économe, visite Las Vegas pour la première fois. Elle n'est pas une joueuse, mais par curiosité, elle met une pièce dans la machine à sous, puis une autre, et une autre. Rien ne se passe. Deux dollars en trimestres plus tard, sa curiosité s'estompe et elle est sur le point de démissionner. Mais ensuite, la machine s'allume, les cloches sonnent et Sarah récupère 50 pièces. C'est plutôt ça ! Sarah recommence à insérer des trimestres avec un intérêt renouvelé, et quelques minutes plus tard, elle a épuisé tous ses gains et est dans le trou de 10$. C'est peut-être le bon moment pour arrêter de fumer. Et pourtant, elle continue à investir de l'argent dans la machine à sous parce qu'elle ne sait jamais quand le prochain renfort arrivera. Elle n'arrête pas de penser qu'au prochain trimestre, elle pourrait gagner 50$, ou 100$, voire plus. Comme le calendrier de renforcement de la plupart des types de jeux de hasard a un calendrier à ratio variable, les gens continuent d'essayer et d'espérer gagner gros la prochaine fois. C'est l'une des raisons pour lesquelles le jeu est si addictif et si résistant à l'extinction.

Lors du conditionnement opérant, l'extinction d'un comportement renforcé se produit à un moment donné après l'arrêt du renforcement, et la vitesse à laquelle cela se produit dépend du calendrier de renforcement. Dans un calendrier à ratio variable, le point d'extinction arrive très lentement, comme décrit ci-dessus. Mais dans les autres programmes de renforcement, l'extinction peut survenir rapidement. Par exemple, si June appuie sur le bouton du médicament antidouleur avant que son médecin n'ait approuvé le temps imparti, aucun médicament n'est administré. Elle suit un programme de renforcement à intervalles fixes (dosés toutes les heures), de sorte que l'extinction se produit rapidement lorsque le renforcement n'arrive pas à l'heure prévue. Parmi les programmes de renforcement, le ratio variable est le plus productif et le plus résistant à l'extinction. L'intervalle fixe est la méthode la moins productive et la plus facile à éteindre (Figure 6.13).

Skinner (1953) a déclaré : « Si l'établissement de jeu ne parvient pas à persuader un client de remettre de l'argent sans retour, il peut obtenir le même effet en remboursant une partie de l'argent du client selon un calendrier à ratio variable » (p. 397).

Skinner utilise le jeu comme exemple de la puissance du programme de renforcement à ratio variable pour maintenir le comportement même pendant de longues périodes sans aucun renforcement. En fait, Skinner était tellement confiant dans ses connaissances sur la dépendance au jeu qu'il a même prétendu pouvoir transformer un pigeon en joueur pathologique (« Skinner's Utopia », 1971). Il est vrai que les horaires à ratio variable maintiennent un comportement assez persistant. Imaginez la fréquence des crises de colère d'un enfant si un parent cède ne serait-ce qu'une seule fois à ce comportement. La récompense occasionnelle rend presque impossible l'arrêt du comportement.

Des recherches récentes sur des rats n'ont pas étayé l'idée de Skinner selon laquelle l'entraînement selon des horaires à ratio variable provoque à lui seul un jeu pathologique (Laskowski et al., 2019). Cependant, d'autres recherches suggèrent que le jeu semble agir sur le cerveau de la même manière que la plupart des drogues qui créent une dépendance, et qu'il pourrait donc y avoir une combinaison de chimie cérébrale et de calendrier de renforcement qui pourrait mener au jeu compulsif (Figure 6.14). Plus précisément, des recherches modernes montrent le lien entre le jeu et l'activation des centres de récompense du cerveau qui utilisent le neurotransmetteur (substance chimique du cerveau) dopamine (Murch & Clark, 2016). Il est intéressant de noter que les joueurs n'ont même pas besoin de gagner pour faire l'expérience de la « ruée » de dopamine dans le cerveau. Il a également été démontré que les « accidents évités de justesse », c'est-à-dire la quasi-victoire mais pas réellement la victoire, augmentent l'activité du striatum ventral et d'autres centres de récompense du cerveau qui utilisent la dopamine (Chase et Clark, 2010). Ces effets sur le cerveau sont presque identiques à ceux produits par des drogues addictives comme la cocaïne et l'héroïne (Murch & Clark, 2016). Sur la base des preuves neuroscientifiques démontrant ces similitudes, le DSM-5 considère désormais le jeu comme une addiction, tandis que les versions antérieures du DSM classaient le jeu comme un trouble du contrôle des impulsions.

Outre la dopamine, le jeu semble également impliquer d'autres neurotransmetteurs, notamment la norépinéphrine et la sérotonine (Potenza, 2013). La norépinéphrine est sécrétée lorsqu'une personne ressent du stress, de l'excitation ou des sensations fortes. Il se peut que les joueurs pathologiques utilisent le jeu pour augmenter leur taux de ce neurotransmetteur. Les carences en sérotonine peuvent également contribuer à un comportement compulsif, notamment à une dépendance au jeu (Potenza, 2013).

Il se peut que le cerveau des joueurs pathologiques soit différent de celui des autres personnes, et peut-être que cette différence a conduit d'une manière ou d'une autre à leur dépendance au jeu, comme ces études semblent le suggérer. Cependant, il est très difficile d'en déterminer la cause car il est impossible de mener une véritable expérience (il serait contraire à l'éthique d'essayer de transformer des participants choisis au hasard en joueurs compulsifs). Il se peut donc que la causalité évolue dans la direction opposée. Peut-être que le fait de jouer modifie d'une manière ou d'une autre les niveaux de neurotransmetteurs dans le cerveau de certains joueurs. Il est également possible qu'un facteur négligé, ou une variable confusionnelle, ait joué un rôle à la fois dans la dépendance au jeu et dans les différences de chimie du cerveau.

Cognition et apprentissage latent

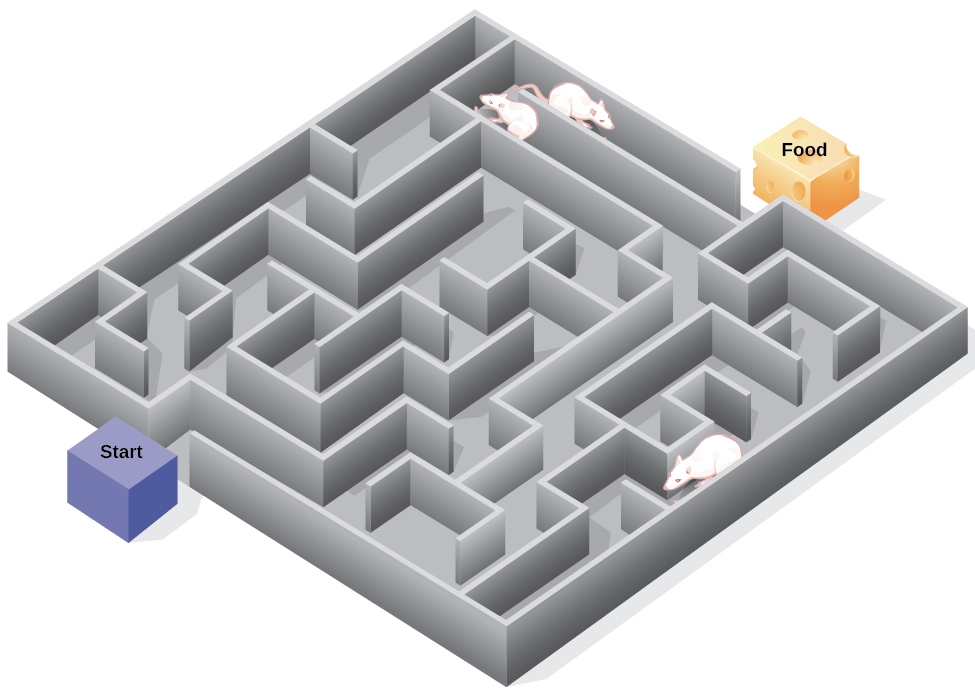

Des comportementalistes stricts tels que Watson et Skinner se sont concentrés exclusivement sur l'étude du comportement plutôt que sur la cognition (comme les pensées et les attentes). En fait, Skinner croyait tellement que la cognition importait peu que ses idées étaient considérées comme du comportementalisme radical. Skinner considérait l'esprit comme une « boîte noire », quelque chose de complètement inconnaissable, et donc quelque chose à ne pas étudier. Cependant, un autre comportementaliste, Edward C. Tolman, avait une opinion différente. Les expériences de Tolman sur des rats ont démontré que les organismes peuvent apprendre même s'ils ne reçoivent pas de renforcement immédiat (Tolman et Honzik, 1930 ; Tolman, Ritchie et Kalish, 1946). Cette constatation allait à l'encontre de l'idée dominante à l'époque selon laquelle le renforcement doit être immédiat pour que l'apprentissage se produise, suggérant ainsi un aspect cognitif à l'apprentissage.

Au cours des expériences, Tolman a placé des rats affamés dans un labyrinthe sans aucune récompense pour s'y être frayés un chemin. Il a également étudié un groupe témoin qui était récompensé par de la nourriture à la fin du labyrinthe. Alors que les rats non renforcés exploraient le labyrinthe, ils ont développé une carte cognitive : une image mentale de la disposition du labyrinthe (Figure 6.15). Après 10 séances dans le labyrinthe sans renforcement, de la nourriture a été placée dans une boîte de but au bout du labyrinthe. Dès que les rats ont pris conscience de la nourriture, ils ont pu se frayer un chemin dans le labyrinthe rapidement, tout aussi rapidement que le groupe témoin, qui avait été récompensé par de la nourriture depuis le début. C'est ce que l'on appelle l'apprentissage latent : un apprentissage qui se produit mais qui n'est pas observable dans le comportement tant qu'il n'y a pas de raison de le démontrer.

Vous êtes-vous déjà perdu dans un bâtiment et ne parvenez-vous pas à en sortir ? Bien que cela puisse être frustrant, vous n'êtes pas seul. À un moment ou à un autre, nous nous sommes tous perdus dans des lieux tels qu'un musée, un hôpital ou une bibliothèque universitaire. Chaque fois que nous nous rendons dans un nouvel endroit, nous établissons une représentation mentale (ou carte cognitive) de l'endroit, comme les rats de Tolman construisaient une carte cognitive de leur labyrinthe. Cependant, certains bâtiments prêtent à confusion, car ils comprennent de nombreuses zones qui se ressemblent ou offrent des lignes de visibilité courtes. De ce fait, il est souvent difficile de prévoir ce qui se passe dans un coin de rue ou de décider de tourner à gauche ou à droite pour sortir d'un bâtiment. La psychologue Laura Carlson (2010) suggère que ce que nous plaçons dans notre carte cognitive peut avoir un impact sur notre capacité à naviguer dans l'environnement. Elle suggère que le fait de prêter attention à des caractéristiques spécifiques lorsque vous entrez dans un bâtiment, comme une image accrochée au mur, une fontaine, une statue ou un escalator, ajoute des informations à notre carte cognitive qui peuvent être utilisées plus tard pour nous aider à trouver le chemin à suivre pour sortir du bâtiment.