1.3 : Le rôle des systèmes d'information

- Page ID

- 167198

Maintenant que nous avons exploré les différentes composantes des systèmes d'information (SI), nous devons porter notre attention sur le rôle des SI au sein d'une organisation. D'après nos définitions ci-dessus, nous voyons que ces composants collectent, stockent, organisent et distribuent des données dans l'ensemble de l'organisation, ce qui constitue la première moitié de la définition. Nous pouvons maintenant nous demander ce que ces composants font réellement pour une organisation afin de répondre à la deuxième partie de la définition d'un SI « pour soutenir la prise de décision, la coordination, le contrôle, l'analyse et la visualisation dans une organisation ». Plus tôt, nous avons discuté de la manière dont le SI collecte des données brutes pour les organiser afin de créer de nouvelles des informations destinées à faciliter la gestion d'une entreprise. Pour aider la direction à prendre des décisions critiques éclairées, le SI doit aller plus loin en les transformant en connaissances organisationnelles. En fait, on pourrait dire que l'un des rôles du SI est de prendre des données et de les transformer en informations, puis de les transformer en connaissances organisationnelles. À mesure que la technologie s'est développée et que le monde des affaires est de plus en plus axé sur les données, le rôle du SI a évolué, qu'il s'agisse d'un outil permettant de gérer une organisation de manière efficace ou d'un outil stratégique pour obtenir Pour avoir une idée complète du rôle des SI, nous examinerons comment les SI ont évolué au fil des ans afin de créer de nouvelles opportunités pour les entreprises et de répondre à l'évolution des besoins humains.

Les premières années (1930-1950)

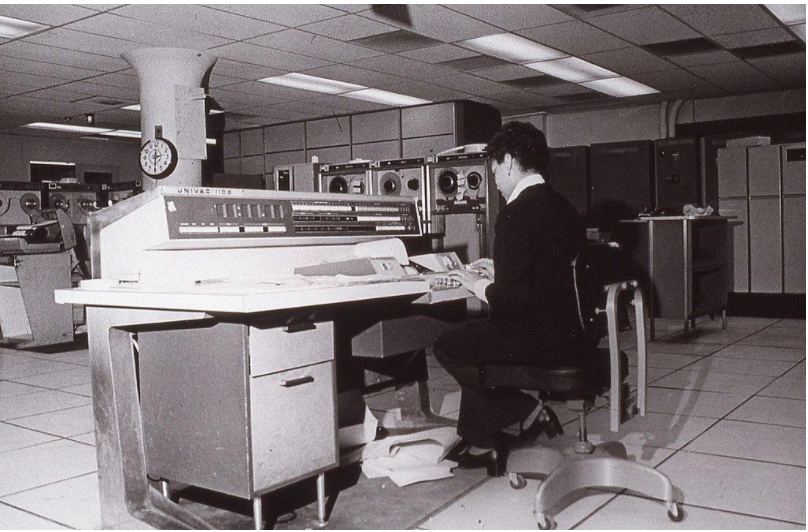

On peut dire que l'histoire de l'informatique a été rendue publique dans les années 1930 lorsque George Stibitz a développé l'additionneur « Model K » sur sa table de cuisine à l'aide des relais des compagnies de téléphone et a prouvé la viabilité du concept de « logique booléenne », un concept fondamental dans la conception des ordinateurs. À partir de 1939, nous avons assisté à l'évolution des équipements spéciaux vers des ordinateurs à usage général par des entreprises désormais emblématiques de l'industrie informatique : Hewlett-Packard avec son premier produit, l'oscillateur audio HP200A utilisé par Disney's Fantasia. Les années 1940 nous ont donné le premier programme informatique exécutant un ordinateur grâce aux travaux de John von Newmann, Frederic Williams, Tom Kilburn et Geoff Toothill. Les années 1950 nous ont donné le premier ordinateur commercial, l'UNIVAC 1, fabriqué par Remington Rand et livré au Bureau du recensement des États-Unis ; il pesait 29 000 livres et coûtait plus de 1 million de dollars chacun. (Computer History Museum, s.d.)

Le logiciel a évolué en même temps que l'évolution du matériel. Grace Hopper a terminé A-0, le programme qui permettait aux programmeurs de saisir des instructions sur le matériel avec des mots de type anglais sur l'UNIVAC 1. Avec l'arrivée des ordinateurs généraux et commerciaux, nous sommes entrés dans ce que l'on appelle aujourd'hui l'ère des ordinateurs centraux. (Computer History Museum, s.d.)

L'ère des ordinateurs centraux

De la fin des années 1950 aux années 1960, les ordinateurs étaient considérés comme plus efficaces pour effectuer des calculs. Ces premiers ordinateurs professionnels étaient des monstres de la taille d'une pièce, reliés entre eux par plusieurs machines de la taille d'un réfrigérateur. La tâche principale de ces appareils était d'organiser et de stocker de gros volumes d'informations qu'il était fastidieux de gérer manuellement. D'autres entreprises ont été fondées pour développer le secteur du matériel informatique et des logiciels, telles que Digital Equipment Corporation (DEC), RCA et IBM. Seules les grandes entreprises, les universités et les agences gouvernementales pouvaient se les permettre, et il a fallu une équipe de personnel spécialisé et des installations spécialisées pour les installer.

IBM a présenté System/360 avec cinq modèles. Il a été salué comme une étape majeure dans l'histoire de l'informatique car il était destiné aux entreprises en plus des clients scientifiques existants et, ce qui est tout aussi important, tous les modèles pouvaient exécuter le même logiciel (Computer History, s.d.). Ces modèles peuvent servir jusqu'à des centaines d'utilisateurs à la fois grâce à la technique appelée temps partagé. Les fonctions typiques incluaient les calculs scientifiques et la comptabilité dans le cadre plus large du « traitement des données ».

À la fin des années 1960, les systèmes de planification des ressources de fabrication (MRP) ont été introduits. Ce logiciel, exécuté sur un ordinateur central, a permis aux entreprises de gérer le processus de fabrication, le rendant ainsi plus efficace. Du suivi des stocks à la création de nomenclatures en passant par la planification de la production, les systèmes MRP (et plus tard les systèmes MRP II) ont donné à davantage d'entreprises une raison d'intégrer l'informatique à leurs processus. IBM est devenue la principale entreprise de mainframe. Surnommée « Big Blue », l'entreprise est devenue synonyme d'informatique professionnelle. L'amélioration continue des logiciels et la disponibilité de matériel moins onéreux ont fini par faire entrer les ordinateurs centraux (et leur petit frère, le mini-ordinateur) dans la plupart des grandes entreprises.

La révolution informatique

Les années 1970 ont marqué le début de l'ère de la croissance en fabriquant à la fois des ordinateurs plus petits (des micro-ordinateurs) et des machines plus rapides (des superordinateurs). En 1975, le premier micro-ordinateur a été annoncé sur la couverture de Popular Mechanics : l'Altair 8800, inventé par Ed Roberts, qui a inventé le terme « ordinateur personnel ». L'Altair a été vendu pour 297 à 395 dollars, était livré avec 256 octets de mémoire et était sous licence pour le langage de programmation BASIC de Bill Gates et Paul Allen. Sa popularité immédiate a éveillé l'imagination des entrepreneurs du monde entier, et des dizaines d'entreprises ont rapidement fabriqué ces « ordinateurs personnels ». Bien qu'il ne s'agisse au début que d'un produit de niche destiné aux amateurs d'informatique, l'amélioration de la convivialité et de la disponibilité pratique des logiciels a entraîné une augmentation des ventes. Le plus important de ces premiers fabricants d'ordinateurs personnels était une petite entreprise connue sous le nom d'Apple Computer, dirigée par Steve Jobs et Steve Wozniak, avec le succès « Apple II ». (Computer History Museum, s.d.)

Les fabricants de matériel informatique tels qu'Intel et Motorola ont continué à introduire des microprocesseurs de plus en plus rapides (c'est-à-dire des puces informatiques). Ne voulant pas être à l'écart de la révolution, IBM (en collaboration avec une petite entreprise appelée Microsoft pour ses logiciels de système d'exploitation) a publié en 1981 sa propre version de l'ordinateur personnel, appelée « PC ». Les entreprises, qui utilisaient des ordinateurs centraux IBM depuis des années pour gérer leurs activités, ont finalement obtenu l'autorisation dont elles avaient besoin pour intégrer des ordinateurs personnels à leurs entreprises, et le PC IBM a pris son envol. Le PC IBM a été nommé « Homme de l'année » par le magazine Time en 1982.

Grâce à l'architecture ouverte du PC IBM, il était facile pour d'autres entreprises de le copier ou de le « cloner ». Au cours des années 1980, de nombreuses nouvelles sociétés informatiques ont vu le jour, proposant des versions moins coûteuses du PC. Cela a fait baisser les prix et a stimulé l'innovation. Microsoft a développé son système d'exploitation Windows et a rendu le PC encore plus facile à utiliser. Les utilisations courantes du PC pendant cette période comprenaient le traitement de texte, les feuilles de calcul et les bases de données. Ces premiers ordinateurs n'étaient connectés à aucun réseau ; dans la plupart des cas, ils constituaient à eux seuls des îlots d'innovation au sein de l'organisation au sens large. Le prix des PC devient de plus en plus abordable avec de nouvelles entreprises telles que Dell.

Aujourd'hui, nous assistons à la miniaturisation des PC dans une nouvelle gamme de périphériques matériels tels que les ordinateurs portables, l'iPhone d'Apple, l'Amazon Kindle, Google Nest et l'Apple Watch. Non seulement les ordinateurs sont devenus plus petits, mais ils sont également devenus plus rapides et plus puissants ; les gros ordinateurs, à leur tour, sont devenus des superordinateurs, IBM Inc. et Cray Inc. figurant parmi les principaux fournisseurs.

Client-Serveur

Au milieu des années 1980, les entreprises ont commencé à prendre conscience de la nécessité de connecter leurs ordinateurs pour collaborer et partager des ressources. Cette architecture réseau était appelée « client-serveur » car les utilisateurs se connectaient au réseau local (LAN) à partir de leur PC (le « client ») en se connectant à un puissant ordinateur appelé « serveur », qui leur accordait ensuite des droits sur différentes ressources du réseau (telles que des zones de fichiers partagées et un imprimante). Les éditeurs de logiciels ont commencé à développer des applications qui permettaient à plusieurs utilisateurs d'accéder aux mêmes données en même temps. Cela a évolué vers des applications logicielles de communication, la première utilisation courante du courrier électronique étant apparue à cette époque.

Ce réseautage et ce partage de données sont restés dans les limites de chaque entreprise, pour la plupart. Bien qu'il y ait un partage de données électroniques entre les entreprises, il s'agissait d'une fonction très spécialisée. Les ordinateurs étaient désormais considérés comme des outils permettant de collaborer en interne au sein d'une organisation. En fait, les réseaux de ces ordinateurs devenaient si puissants qu'ils remplaçaient bon nombre des fonctions précédemment assurées par les gros ordinateurs centraux pour une fraction du coût.

À cette époque, les premiers systèmes de planification des ressources d'entreprise (ERP) ont été développés et exécutés sur l'architecture client-serveur. Un système ERP est une application logicielle dotée d'une base de données centralisée qui peut être utilisée pour gérer l'ensemble des activités d'une entreprise. Avec des modules distincts pour la comptabilité, les finances, les stocks, les ressources humaines et bien d'autres encore, les systèmes ERP, avec SAP en Allemagne en tête, représentent la pointe de l'innovation en matière d'intégration des systèmes d'information. Nous aborderons les systèmes ERP dans le cadre du chapitre sur les processus (chapitre 9).

Internet, World Wide Web et Web 1.0

Les réseaux, la communication et les technologies logicielles évoluent à toutes les époques : le modem dans les années 1940, le lien cliquable dans les années 1950, le courrier électronique en tant qu' « application tueuse » et désormais emblématique « @ », les réseaux mobiles dans les années 1970, et l'essor précoce des communautés en ligne grâce à des entreprises telles que AOL au début des années 1980. Inventé pour la première fois en 1969 dans le cadre d'un projet financé par le gouvernement américain appelé ARPA, Internet a été réservé aux universités, aux agences gouvernementales et aux chercheurs pendant de nombreuses années. Cependant, la complexité de l'utilisation d'Internet l'a rendu impropre à une utilisation courante dans les entreprises.

Une exception à cette règle a été la possibilité d'étendre le courrier électronique en dehors des limites d'une seule organisation. Alors que les premiers messages électroniques sur Internet ont été envoyés au début des années 1970, les entreprises qui souhaitaient étendre leur messagerie sur le réseau local ont commencé à se connecter à Internet dans les années 1980. Les entreprises ont commencé à connecter leurs réseaux internes à Internet pour communiquer entre leurs employés et ceux d'autres entreprises. Avec ces premières connexions Internet, l'ordinateur a véritablement commencé à évoluer d'un appareil informatique à un appareil de communication.

En 1989, Tim Berners-Lee du laboratoire du CERN a développé une application (CERN, s.d.), un navigateur, afin de fournir une interface utilisateur graphique plus simple et plus intuitive aux technologies existantes, telles que les liens cliquables, afin de rendre la possibilité de partager et de localiser de grandes quantités d'informations facilement accessible au grand public ajout aux chercheurs. C'est ce que nous avons appelé le World Wide Web. 4 Cette invention est devenue le point de départ de la croissance d'Internet en tant que moyen pour les entreprises de partager des informations les concernant et pour les consommateurs de les trouver facilement.

Les navigateurs Web et les connexions Internet devenant la norme, les entreprises du monde entier se sont empressées de saisir des noms de domaine et de créer des sites Même les individus créaient des sites Web personnels pour publier des photos à partager avec leurs amis et leur famille. Pour la première fois, les utilisateurs pouvaient créer eux-mêmes du contenu et rejoindre l'économie mondiale.

En 1991, la National Science Foundation, qui régissait l'utilisation d'Internet, a levé les restrictions à son utilisation commerciale. Ces changements de politique ont permis à de nouvelles entreprises de créer de nouveaux secteurs du commerce électronique tels qu'eBay et Amazon.com. L'expansion rapide du marché numérique a entraîné le boom de la dot-com à la fin des années 1990, puis l'effondrement de la dot-com en 2000. L'un des résultats importants de la période de boom d'Internet a été que des milliers de kilomètres de connexions Internet ont été établis dans le monde entier pendant cette période. Le monde est devenu véritablement « branché » à l'aube du nouveau millénaire, inaugurant ainsi l'ère de la mondialisation, dont nous parlerons au chapitre 11.

Le monde numérique est également devenu plus dangereux à mesure que de plus en plus d'entreprises et d'utilisateurs étaient connectés dans le monde entier. Autrefois lentement propagés par le biais du partage de disques informatiques, les virus et les vers informatiques pouvaient désormais se développer à une vitesse phénoménale via Internet et la prolifération de nouveaux dispositifs matériels destinés à un usage personnel ou domestique. Les logiciels d'exploitation et d'application ont dû évoluer pour se défendre contre cette menace, et une toute nouvelle industrie de la sécurité informatique et Internet a vu le jour à mesure que les menaces augmentaient et devenaient de plus en plus sophistiquées. Nous étudierons la sécurité de l'information au chapitre 6.

Web 2.0 et commerce électronique

Peut-être avez-vous remarqué qu'à l'époque du Web 1.0, les utilisateurs et les entreprises pouvaient créer du contenu mais ne pouvaient pas interagir directement entre eux sur un site Web. Malgré l'effondrement d'Internet, les technologies continuent d'évoluer en raison des besoins croissants des clients qui souhaitent personnaliser leur expérience et interagir directement avec les entreprises.

Les sites Web deviennent interactifs ; au lieu de simplement visiter un site pour découvrir une entreprise et acheter ses produits, les clients peuvent désormais interagir directement avec les entreprises et, plus profondément, les clients peuvent également interagir entre eux pour partager leur expérience sans influence indue de la part des entreprises ou même sans acheter des produits directement les uns auprès des autres. Ce nouveau type de site Web interactif, où les utilisateurs n'avaient pas à savoir comment créer une page Web ou à programmer pour mettre des informations en ligne, est devenu connu sous le nom de Web 2.0.

Le Web 2.0 est illustré par les blogs, les réseaux sociaux, le troc, les achats et la publication de commentaires interactifs sur de nombreux sites Web. Ce nouveau monde du web 2.0, dans lequel l'interaction en ligne était attendue, a eu un impact important sur de nombreuses entreprises et même sur des secteurs entiers. Certaines industries, comme les librairies, se sont retrouvées reléguées au rang de niche. D'autres, comme les chaînes de location de vidéos et les agences de voyages, ont commencé à fermer leurs portes lorsque les technologies en ligne les ont remplacées. Ce processus de remplacement technologique d'un intermédiaire dans une transaction est appelé désintermédiation. L'une de ces entreprises prospères est Amazon, qui a désintermédié de nombreux intermédiaires dans de nombreux secteurs et qui est l'un des principaux sites Web de commerce électronique.

À mesure que le monde devenait plus connecté, de nouvelles questions se sont posées. L'accès à Internet doit-il être considéré comme un droit ? Qu'est-ce qui est légal de copier ou de partager sur Internet ? Comment les entreprises peuvent-elles protéger la confidentialité des données (conservées ou fournies par les utilisateurs) ? Certaines lois doivent-elles être mises à jour ou créées pour protéger les données des personnes, y compris celles des enfants ? Les décideurs politiques sont toujours en train de rattraper les avancées technologiques, même si de nombreuses lois ont été mises à jour ou créées. Les questions éthiques relatives aux systèmes d'information seront abordées au chapitre 12.

Le monde de l'après-PC et du Web 2.0

Après trente ans en tant que principal appareil informatique utilisé dans la plupart des entreprises, les ventes de PC commencent à baisser à mesure que les tablettes et les smartphones prennent de l'ampleur. Tout comme l'ordinateur central avant lui, le PC continuera de jouer un rôle clé dans les affaires, mais ne sera plus le principal moyen d'interaction ou de gestion des affaires. La puissance de stockage et de traitement limitée de ces appareils mobiles est compensée par le passage à l'informatique « cloud », qui permet le stockage, le partage et la sauvegarde des informations à grande échelle.

Les utilisateurs continuent de faire pression pour des appareils informatiques plus rapides et plus petits. Historiquement, nous avons vu que les micro-ordinateurs ont remplacé les ordinateurs centraux, les ordinateurs portables ont remplacé (presque) les ordinateurs de bureau Nous constatons maintenant que les smartphones et les tablettes remplacent les ordinateurs portables dans de nombreuses situations. Les fournisseurs de matériel vont-ils surmonter les limites physiques dues à la petite taille des appareils ? Est-ce le début d'une nouvelle ère d'invention de nouveaux paradigmes informatiques tels que l'informatique quantique, un sujet tendance que nous aborderons plus en détail au chapitre 13 ?

Des tonnes de contenu ont été générées par les utilisateurs du monde du Web 2.0, et les entreprises monétisent ce contenu généré par les utilisateurs sans partager leurs bénéfices. Comment évoluera le rôle des utilisateurs dans ce nouveau monde ? Les utilisateurs voudront-ils bénéficier d'une part de ce bénéfice ? Les utilisateurs seront-ils enfin propriétaires de leurs propres données ? Quelles nouvelles connaissances peuvent être créées à partir du contenu massif généré par les utilisateurs et les entreprises ?

Le graphique ci-dessous montre l'évolution de certaines des avancées réalisées à ce jour dans le domaine des systèmes d'information.

|

Ère |

Matériel |

Système d'exploitation |

Applications |

|---|---|---|---|

|

Premières années (années 1930) |

Modèle K, équipement de test HP, calculatrice, UNIVAC 1 |

Le premier programme informatique a été écrit pour être exécuté et stocké sur un ordinateur. |

|

|

Mainframe (années 1970) |

Terminaux connectés à un ordinateur central, IBM System 360 |

Temps partagé (TSO) sur MVS |

Logiciel MRP écrit sur mesure |

|

PC (milieu des années 1980) |

PC IBM ou compatible. Parfois connecté à l'ordinateur central via une carte d'extension. Microprocesseur Intel |

MS-DOS |

WordPerfect, Lotus 1-2-3 |

|

Client-Serveur (de la fin des années 80 au début des années 90) |

« Clone » d'un PC IBM sur un réseau Novell. L'Apple-1 d'Apple |

Windows pour groupes de travail, macOS |

Microsoft Word, Microsoft Excel, courrier électronique |

|

World Wide Web (du milieu des années 90 au début des années 2000) |

« Clone » d'un PC IBM connecté à l'intranet de l'entreprise. |

Windows XP, macOS |

Microsoft Office, Internet Explorer |

|

Web 2.0 (du milieu des années 2000 à aujourd'hui) |

Ordinateur portable connecté au Wi-Fi de l'entreprise. Smartphones |

Windows 7, Linux, macOS |

Microsoft Office, Firefox, plateformes de réseaux sociaux, blogs, recherche, textos |

|

Post-Web 2.0 (aujourd'hui et au-delà) |

iPad d'Apple, robots, Fitbit, montre, Kindle, Nest, voitures, drones |

iOS, Android, Windows 10 |

Sites Web adaptés aux mobiles, plus d'applications mobiles Commerce électronique |

Il semble que nous nous trouvions à un point critique de nombreuses avancées technologiques qui sont arrivées à maturité. La miniaturisation d'appareils tels que les caméras, les capteurs, les processeurs plus rapides et plus petits, les avancées logicielles dans des domaines tels que l'intelligence artificielle, associées à la disponibilité de données massives, ont commencé à faire apparaître de nouveaux types d'appareils informatiques, petits et grands, capables de faire des choses inédites dans ces quarante dernières années. Un robot de la taille d'une mouche est déjà peu utilisé, une voiture sans conducteur est en phase d'essai dans quelques villes, entre autres nouvelles avancées pour répondre aux besoins actuels des clients et en anticiper de nouveaux pour l'avenir. « Où allons-nous à partir d'ici ? » est une question que vous participez maintenant à la conversation au fur et à mesure que vous parcourez les autres chapitres. Nous ne savons peut-être pas exactement à quoi ressemblera l'avenir, mais nous pouvons raisonnablement supposer que les systèmes d'information toucheront presque tous les aspects de nos normes sociales personnelles, professionnelles et personnelles, locales et mondiales. Êtes-vous prêt à devenir un utilisateur encore plus averti ? Vous préparez-vous à être compétitif dans le domaine que vous avez choisi ? Y a-t-il de nouvelles normes à adopter ?

Références

Chronologie de l'histoire de l'informatique : Musée d'histoire informatique. (n.d.). Consulté le 10 juillet 2020 sur https://www.computerhistory.org/timeline/computers/

CERN. (n.d.) La naissance du Web. Consulté de http://public.web.cern.ch/public/en/about/web-en.html